关于SEO,相信各位电商界的精英们对该词都不陌生,简单的说就是利用某些技术,使网站的某一关键字在搜索引擎中自然排名靠前的方法。通过该方法,可以有效的为网站带来流量,带来流量之后对于网站主而言,应该去做的就是如何使这些流量产生可观的价值。

排除误区

1、仅仅“内容为王,外链为皇”是不够的!

很多地方都说“SEO技术说直白点就是‘内容为王,外链为皇’的技术。”其实也不假,有良好的内容资源,再加上可观的外链数目,确实能够明显的提高站点的自然排名,但是仅仅是这样去总结SEO技术,是肯定不对的,因为SEO技术所要的,除了上面提到的内容和外链数量之外,SEO技术还需要的是执行力。如果仅仅按照前面的那句总结性的文字,估计肯定会有很多朋友会产生的这样的疑问——“如果我疯狂的发布文章,疯狂的发布外链,我的站点排名就可以快速的爬到自然排名第一吗?”关于这个问题,答案肯定是否定的,因为SEO是个持续性的工作,而并非一个一劳永逸的技术。

2、关键字并非站点名称!

以上粗略介绍了如何对站点进行SEO的一些方法:内容+外链,以及何为关键字。

屏蔽搜索引擎爬虫

众所周知,一个网站想要被搜索引擎收录,肯定需要有相关搜索引擎的爬虫造访,才会被正常收录的,但是很多初建网站的网站主常常会发现一个问题,那就是可能今天站点被正常收录了,但是明天可能就找不到了,关于这个问题,其实有两种可能。

可能一:由于是新建站点,站点可能在被收录之后丢进了黑盒,俗称“考察期”,经过一段时间的正常稳定的发展,站点即会被丢出黑盒,重新被显示出来;

可能二:由于是新建站点,站点可能会在一定时间内,进行这样或那样频繁的调整,比如站点改版、框架重设等,这样就会使得爬虫认为站点极不稳定,导致爬虫对站点的依赖性降低,从而导致站点消失在搜索结果中。

也是考虑到以上两点,通常做法是站点建站之初,阿呆会在robots.txt文件中屏蔽所有爬虫,待站点有一定的内容基础,并且稳定之后再允许爬虫的访问。

确定关键字

对于一个刚刚上线的站点而言,如何选择关键字,如何选择发展方向,是重中之重,所以这个时候通常做法是,先依次分析与站点有关的关键字,然后在其中选择一个难度较小,但是指数很高的关键字进行发展,这里需要解释两个概念。

关键字难度:意思就是说,在日后的操作过程中能够快速看见效果的关键字;

关键字指数:指的是每日该关键字在搜索引擎的提交次数。

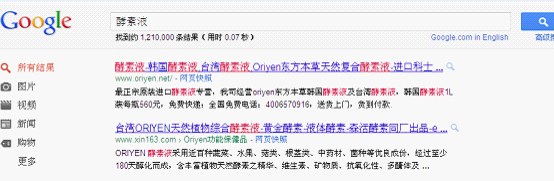

首先查看关键字指数(百度有相关的查询页面——百度指数),然后直接在搜索引擎内搜索该关键字,这时会获得相关页面数量,最后该关键字指数与该关键字相关页面数量的比值即为该关键字的难度,该数值越接近1,证明难度越小,这样也就能够确定关键字。

用户体验 对于站点而言,SEO固然重要,但是SEO最终面对的,还是那些爬虫,还是那些程序代码,其实对于SEO,作为站长的我们,我们还需要去考虑UEO(用户体验优化),因为对于站长而言,最终希望的还是能留住用户,而留住用户的方法,其实就是在内容建设的基础之上,从用户角度出发,最大化的为用户考虑,能够起到便捷用户、吸引用户、引导用户的所有细节性改观。

文章作者:admin

本文地址:http://www.xueseo.com/seo-in-wuqu

版权所有 © 转载时必须以链接形式注明作者和原始出处!

SEO学员董俊的个人赚钱经验

董俊

2007年第6期S...

SEO学员董俊的个人赚钱经验

董俊

2007年第6期S...

SEO学员小明的赚钱之路

网址:www.oriyen....

SEO学员小明的赚钱之路

网址:www.oriyen....

王通:我的创业经历

我是在2000年的时...

王通:我的创业经历

我是在2000年的时...

王通:SEO学员案例:纯翠网

电子商务市场...

王通:SEO学员案例:纯翠网

电子商务市场...

王通:SEO学员案例:敬老网

敬老网

网址:www....

王通:SEO学员案例:敬老网

敬老网

网址:www....